CGで実現する未来の手話サービス

内田 翼

森田 祐介

金子 浩之

佐野 雅規

スマートプロダクション研究部

NHKが取り組むユニバーサルサービスのひとつに,耳の聞こえない方に向けた手話サービスがある。NHK技研では緊急報道や長時間番組など手話キャスターや通訳者の対応が難しい場合の制作支援を目的として,CGアニメーションを利用した手話CGの技術開発を進めている。本講演では,言語である手話をCGアニメーションで再現する課題を説明し,手話CGの仕組みについて紹介する。さらに,当所で取り組んでいる,気象やスポーツの配信データにもとづいた穴埋め方式のCG生成技術と,自由に記述された日本語文から手話CGを生成するための要素技術を紹介する。

1.はじめに

当所では,視覚・聴覚に障害のある人や高齢者,外国人を含むあらゆる人々に,情報を分かりやすく届けるためのメディアアクセシビリティー技術の研究開発に取り組んでいる。その中で特に,聴覚に障害があり手話による情報提供が必要な方に向けて研究開発を進めているのが,手話をCG(Computer Graphics)アニメーションで再現する技術(以下,手話CG)である。手話CGをさまざまなコンテンツ制作に活用することで,手話による情報提供を拡充することができる。

本講演では,手話の言語的な特徴やCGアニメーションを用いる利点について説明し,当所で取り組んでいる手話CGを活用したサービスの事例や,自由に記述された日本語文から手話CGを生成する最新の取り組みについて紹介する。

2.手話による情報提供の必要性

過去の全国調査1)の結果を見ると,日本国内では約6万人が手話を日常的にコミュニケーション手段としており,それは,聴覚・言語障害者の18.9%を占めている。その中には,生まれつき耳が不自由で,幼少期から日本語よりも手話を主なコミュニケーション手段として利用してきた手話母語話者,つまり,手話を母語(第一言語)*1とする人たちもいる。そういった手話母語話者たちにとっては,日本語の意味が直感的に理解しづらかったり,日本語を読むこと自体が大きな負荷になってしまうこともある。つまり,手話母語話者にとって,例えば,放送などにおいて日本語の字幕だけで情報保障*2されることは,健聴者が慣れない外国語の字幕だけから情報を入手しなければならない感覚に近い。そのため,字幕に加えて手話でも情報を提供する必要がある。最近では,手話の重要性が徐々に理解され始め,会見や放送,映画や舞台など,さまざまな場面で手話を目にする機会が増えてきた。手話を言語と位置づける「手話言語条例」を制定する動きが,全国的に広がっていることなどからも明らかである*3。一方で,厚生労働省の認定する公的資格である手話通訳士の数は全国で3,930人(2022年4月14日時点)である。その数は放送をはじめとするさまざまなコンテンツに手話による情報保障を付けるためには,まだ十分ではなく,アクセシビリティー向上が課題である。当所では,人による通訳で補えない部分をCGアニメーションで代替し,手話サービスを増やす目的で手話CGの研究開発を進めている。

3.CGアニメーションによる手話の活用

手話による情報提供は手話キャスターや手話通訳者が対応することが望ましいが,緊急時に情報提供が必要な場面ではCGアニメーションの活用も期待される。放送局の中に手話キャスターが常時待機することは難しいため,深夜早朝の発災時などにおける災害情報や避難情報の提供に手話CGの利用が考えられる。手話CGを用いた迅速な初動対応によって,手話キャスターによる情報提供の体制が整うまでの空白を補うことができる。

また,長時間の情報提供が可能という点も手話CGの利点である。長時間の手話通訳は身体的な負担が大きく,手指や腕,肩,首の筋肉や関節に痛みやしびれが生じる頸肩腕障害が職業病として問題になっている。また,疲労の蓄積により通訳の品質低下も懸念されるため,ひとりの手話通訳者が連続して通訳を行うことができるのは通常15〜20分と言われている*4。一方,手話CGであれば,疲れることもなく常に一定の品質の手話で情報提供し続けることができる。

4.手話の言語的な特徴

CGアニメーションで手話を再現するにあたって,課題となるのが日本語と手話の言語的な違いである。手話は日本語とは文法や語彙が異なる自然言語であり,日本語文の単語をそのままの語順で手話単語に置き換えただけでは,受け手は正確な情報を理解できない。

例えば「あなたはどこに住んでいるのですか?」という日本語文を手話に翻訳した場合,手話では{あなた}{家}{いる}{場所}{何}という語順になり,日本語の「どこ」に相当する{場所}{何}が文末に現れる形になる({ }で囲んだ文字は手話の単語を示す)。これを日本語の語順で{あなた}{場所}{何}{家}{いる}とすると,全く別の意味として理解される可能性がある。

また,手や指の動きだけでなく,顔の表情や口の形(口型)なども,情報を伝える上で重要な非手指動作と言われる文法要素となる。同じ手指の動作をしていても,表情や口型の違いによって意味が変化する。コロナ禍の会見などの場で,手話通訳の方が透明なフェイスシールドを装着するようになったのも,顔に表出されている情報を漏らさずに伝えるためである。

さらに,手話は文脈によって単語を表現する位置や左右の手の組み合わせが変化するため,身体の正面で表現する基本的な単語動作(辞書形)をつないだだけの文章では,内容が正確に伝わらないことが多い。例えば,スポーツの試合で「0対3」といった対戦スコアを手話で表現する場合,辞書形の表現を使って,右手だけで「0」や「3」といった数字を顔の前に順番に出すだけでは不自然な手話になってしまう。自然な手話を表現にするためには,左右の手でそれぞれの数字を出しわけつつ,2つの数字を左右に並べて対比する形で提示する必要がある。

その他にも,手話の速度や大きさ,単語同士の間,うなずきや首振りなどの首の動き,指し示す方向を使い分けた指差し,上半身の姿勢など,さまざまな要素が手話において言語的な文法要素となっている。

CGで自然な手話を生成するには,手話の言語的な特徴を考慮する必要がある。

5.手話CGの仕組み

手話CGの基本原理は,手話の動作をデータとして記録したモーションデータを3D(3-Dimensional)キャラクターモデル(「3Dアバター」と呼ばれることも多い)で再生し,それをレンダリングしてアニメーションとして提示するものである。

CGのキャラクターモデルを動かすための手話モーションデータの収録には,光学式のモーションキャプチャーを使用している(1図)。前後・左右・上下に並べた複数台のモーションキャプチャー専用のカメラを同時に使って,手話の動作を単語やフレーズ単位で収録する。顔にもデータ収録用のマーカーを付けて,手話で重要な顔や口の細かな動きも,手や指の動きと同時に収録している。あらかじめ収録した手話モーションデータを用途に応じて組み合わせて使うことで,手話CGでさまざまな文章を表現することが可能となる。

これまで,手話辞典などに掲載されている手話単語をモーションデータとして蓄積してきた。手話を使われている方々から意見を集めるために,モーションデータを手話CGのアニメーションにした動画を,NHK手話CG評価ホームページ*5上で公開している(2図)。日本語で単語を検索してその動画を確認できる手話単語の辞書のように,手話学習の用途でも多く利用されている。

この手話CGを使ったサービスをいち早く実用化するための第一段階として,穴埋め方式(定型文方式)で手話CGを自動生成する技術の研究開発に着手した。

5.1 穴埋め方式の手話CG

穴埋め方式(定型文方式)は,あらかじめ用意した手話の定型文と決まった形式のデータを組み合わせることで,手話CGを自動生成する方式である(3図)。定型文には文章のところどころに穴が空いており,その穴の部分を可変とし,データから抜き出した固有名詞や数字などを入れることで文章が完成する。

事前に定型文を用意する段階で,使用するすべての日本語文を人手で手話へ翻訳しており,運用時にリアルタイムで翻訳する必要がないため,誤った情報を出力することがなくなる。また,可変部分以外はまとまったフレーズとして収録したモーションデータを利用できるので,単語単位で並んだデータをすべて接続する場合と比べ接続箇所が少なくなることで,より自然な手話が再現できる。そのため,人手による確認や修正などが不要となり,サービスに活用するにあたり運用を自動化できるメリットがある。

当所ではこの穴埋め方式を使って,気象情報とスポーツ実況の2つの分野でサービスの実用化を進めてきた。

(1)気象情報手話CG

ニーズや緊急性が高く,決まった言い回しが多い気象情報からサービス検討を開始し,気象庁から発表される気象情報を利用して,天気予報の手話CGを自動生成する仕組みを開発した2)。

あらかじめ気象情報を伝える定型文や,晴れ/雨などの天気情報,降水確率,予想最高/最低気温の数値などの手話表現をモーションキャプチャーしておく。そして,気象庁が配信する定型フォーマットのデータの中から,天気情報,降水確率,予想気温に該当するデータを抜き出して,定型文の可変部分に挿入することで文章が生成される。

2017年には関東7都県に限定した形で気象情報手話CGの検証サイト*6を公開した。自動生成された手話CGの動画で,地図から選択した地域の最新の気象情報を確認できる。2021年には,気象庁の定めた一次細分区域*7である全国142地点に対象地域を拡充し,検証を継続している(4図)。

(2)スポーツ実況手話CG

気象情報手話CGの仕組みを応用して,スポーツ実況の自動生成に着手した。スポーツにおいても試合中の記録用途で作成される競技データがスポーツ大会主催者から配信され,データ放送やインターネットの速報サービスなどで活用されることが増えており,それを手話CGの自動生成にも利用できる。

競技中に配信される競技データをリアルタイムで利用することで,得点や反則といった試合の状況を説明する手話CGを自動生成して,競技映像視聴中に補足情報として提供する仕組みを開発した3)。手話CGであれば途中で疲れることもなく,試合開始から終了まで長時間に渡って一定の品質を保ったまま手話をし続けることも可能である。配信される競技データを使った実証実験や生成した手話CGの評価実験を繰り返し,2021年の国際的なスポーツ大会において,インターネット配信サービスとして提供した。スポーツ実況手話CGのサービス画面の例を5図に示す。

5.2 翻訳方式の手話CG

穴埋め方式の手話CGによって少しずつサービスを実用化してきたが,現在は,より難しい次のステップとして,自由に記述された日本語文から手話CGを生成することに挑戦している。日本語を英語に翻訳するように,日本語を手話へ翻訳する技術である。しかし,手話は文字による表記方法を持たないため,日本語から英語の翻訳に利用される文字同士の翻訳手法はそのまま利用できない。そのため,翻訳方式では,日本語を手話の単語列へ翻訳し,CG生成部で単語列をもとにモーションデータを接続してCGアニメーションを生成する(6図)。

しかしながら,手話の言語的な特徴を単語列だけで再現することは難しいため,単語列の情報のみから生成した手話CGの課題を,手話母語話者へのデプスインタビュー*8により調査した4)。単語単位のモーションデータを単純に接続しただけの手話CGの10文すべてについて,同じ内容を表現した実写の手話ニュース映像などと比較しながら,不足している文法要素に関する指摘を集めた。手話を表現する上で必要と想定される各文法要素に対して,全6名の実験協力者の指摘の有無を合算した結果を1表に示す。図の左側が指摘回数の多かった文法要素であり,各手話文において値が6となっている文法要素は,すべての実験協力者が再現できていないと指摘した項目になる。その結果,すべての手話文において共通して,単語のまとまりを含む間,空間位置の活用,口型の3項目についての指摘が多かった。この結果によって洗い出された課題について,ひとつずつ解決するためのアプローチを翻訳とCG生成の両面から検討している。翻訳方式の仕組みと併せて説明する。

(1)翻訳部

日本語から手話単語列への翻訳には,人工知能(AI:Artificial Intelligence)による機械翻訳を使用している5)。AIによる翻訳の学習にはニューラルネットワークを用いており,学習データには日本語と手話単語列が文章単位でペアになった大規模な対訳データセットを使用する。現在,学習データとしてNHK手話ニュースの手話映像に対して,日本語音声と映像中に表現された手話を単語ごとに書き起こした15万文対のデータを手話ニュースコーパスとして蓄積している6)(7図)。

学習した翻訳AIに日本語の文章を入力すると,翻訳結果は,{近畿}{東}{海}…のように,手話の単語が時系列に並んだ手話単語列として出力される。この手話単語列の各単語は,あらかじめ収録した手話のモーションデータと紐づけて使用する。

(2)CG生成部

CG生成部では,翻訳結果の手話単語列をもとに,手話モーションのデータベースから各単語に対応するモーションデータを読み込む。読み込んだ複数のモーションデータの間を補間して接続することで,文章単位のモーションデータを生成する。文章のモーションデータをフォトリアル*9な3Dキャラクターモデルに入力して,アニメーションをレンダリングする。

当所では,ユーザーが自由に入力した日本語テキストを手話単語列へ翻訳し,翻訳結果にもとづいて結合した手話モーションを手話CGで確認できる翻訳ツールを試作している(8図)。

(3)翻訳方式の課題と解決方法

先に述べたデプスインタビューの結果のとおり,翻訳結果である手話単語列にしたがって単語のデータを単純に結合しただけでは自然な手話文にはならず,手話特有のさまざまな課題が生じる。

課題のひとつに口型がある。手話単語のモーションデータの口型は,モーションを収録したときの形に固定されてしまう。例えば,地名の「東海(トウカイ)」(( )で囲んだ文字は口型を示す)を表現する場合,手話では{東}と{海}という2つの単語を組み合わせることになる。しかし,モーションキャプチャー時には{東}や{海}などの単語を辞書形で収録しており,それぞれの口型は{東(ヒガシ)},{海(ウミ)}となっている。そのため,そのままのモーションデータを使って文章を生成すると,口型が(トウカイ)ではなく(ヒガシウミ)になってしまう。これでは別の地名として間違えられたり,「東の方の海」という全く別の意味になってしまう。

そこで,口型については,口の周りの動きだけを,あらかじめ口型専用に用意した別のモーションデータと自動で入れ替えて合成する仕組みを入れて改善できるようにしている(9図)。翻訳の段階で日本語文中の固有名詞とその読みの情報を抽出し,その情報をもとにCG生成部でモーションを接続する際に,固有名詞に相当する単語モーションの口のデータを読みに応じたデータに置換する。

その他の課題として,文脈に応じた空間位置の活用がある。「近畿から東海にかけて…」など元の日本語文に地名が複数含まれる場合,地名を表現する手話単語はそれぞれの空間位置を左右にずらすなどして重ならないように表現される。しかし,口型を再現する際の課題としても述べたとおり,手話CGでは基本的に話者正面の位置で表現する辞書形の手話をモーションデータとして収録しているので,すべての単語が常に同じ位置で表現されてしまう。

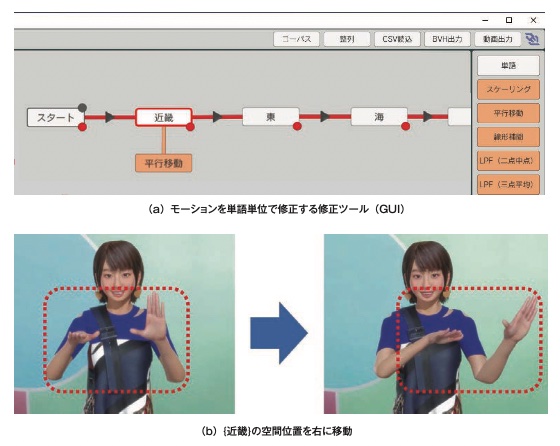

そこで,モーションデータを合成する際にモーションを単語単位で修正するためのツールを開発している7)(10図)。手話の空間位置を変更するだけでなく,速度や大きさを変えたり,左右の手で別々に表現した動作を合成したり,うなずきを付与することができる。翻訳結果が誤っていた場合や,対応するモーションデータが存在しない場合に,手話単語ごとに他のモーションと入れ替えるための機能も実装している。口型の置換処理のように自動化できない部分は,後から手作業で修正することで,可能な限り自然な手話動作に近づけることができるようにしている。

6.まとめ

本講演では,当所で取り組んでいるメディアアクセシビリティー技術のひとつとして,CGアニメーションを利用した手話映像生成技術を紹介した。手話をCGアニメーションで再現するにあたり,手話言語の文法要素となる話者の動きを洗い出し,ひとつひとつの要素を技術的なアプローチで順次解決すべく研究開発を進めている。現在,日本語テキストから手話CGを生成する翻訳方式のプロトタイプシステムが完成した。このプロトタイプシステムに,解決された文法要素を順次取り入れて,より自然な手話の再現を目指している。

まだ解決すべき課題は多いが,今後,翻訳方式の開発が進めば,放送中のアナウンサーの音声などをリアルタイムで音声認識し,それを基に翻訳した手話CGを番組に付けて情報提供するようなサービスにつながるかもしれない。さらに,放送サービスなどの一方的な情報提供だけではなく,放送外の双方向のコミュニケーションへの応用も期待できる。例えば,音声認識だけでなく,手話認識や音声合成といったその他のさまざまな技術と手話CGを組み合わることで,将来的に,聴覚障害者と健聴者の間にあるコミュニケーションの壁が取り払われた社会を実現できる可能性も秘めている。

今後も,手話を必要とする方々に正確な情報を届けるために,さまざまな未来の手話サービスの実現に向けて手話CGの研究開発を続けていく。