シーン記述による360度映像と3次元映像の合成技術

3次元空間コンテンツの制作技術の探究

360度映像や3次元映像に関する技術の標準化動向

360度映像に対応したカメラやヘッドマウントディスプレーの進化に伴い、360度VR (Virtual Reality) コンテンツを体験する機会が増えてきました。これに応じて、360度VRアプリケーションに関するさまざまな技術の標準化も進んでいます。

ここでは、ISO/IEC (International Organization for Standardization/International Electrotechnical Commission:国際標準化機構/国際電気標準会議)におけるマルチメディアの情報処理技術の標準化を行う分科会であるMPEG (Moving Pictures Experts Group)が進めている、360度映像や3次元映像に関する技術の標準化動向を紹介します。

○360度VRコンテンツのファイルフォーマットであるOMAF

OMAF (Omnidirectional Media Format、MPEG-I パート2)は、360度VRコンテンツのファイルフォーマットです。今回開発したシステムでは、サンシャイン水族館の360度映像を格納するファイル形式としてOMAFを用いています。

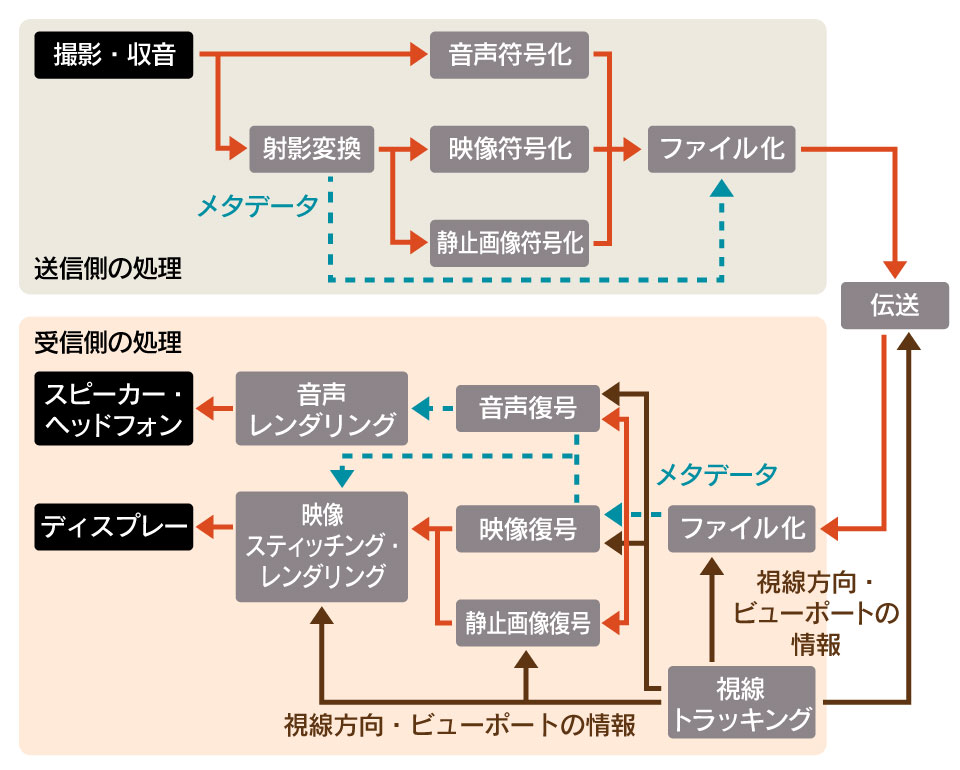

OMAFでは、360度映像を2次元映像に射影変換することで、2次元の映像を対象に開発された映像圧縮符号化技術や配信技術などを活用できます。OMAFにおける360度VRコンテンツの送信側と受信側の処理フローを以下に示します。

撮影した360度映像は、射影変換により矩形の2次元映像に変換されます。圧縮符号化した映像と音声は、360度映像に施した射影変換を特定するメタデータとともにファイル化し、受信側に伝送されます。受信側では、メタデータをもとに送信側と逆の処理を行い、360度映像のうち、ヘッドマウントディスプレー等のセンサーで特定された領域(ビューポート)の映像をレンダリングして表示します。

2.立体的な映像を表現するボリュメトリック映像

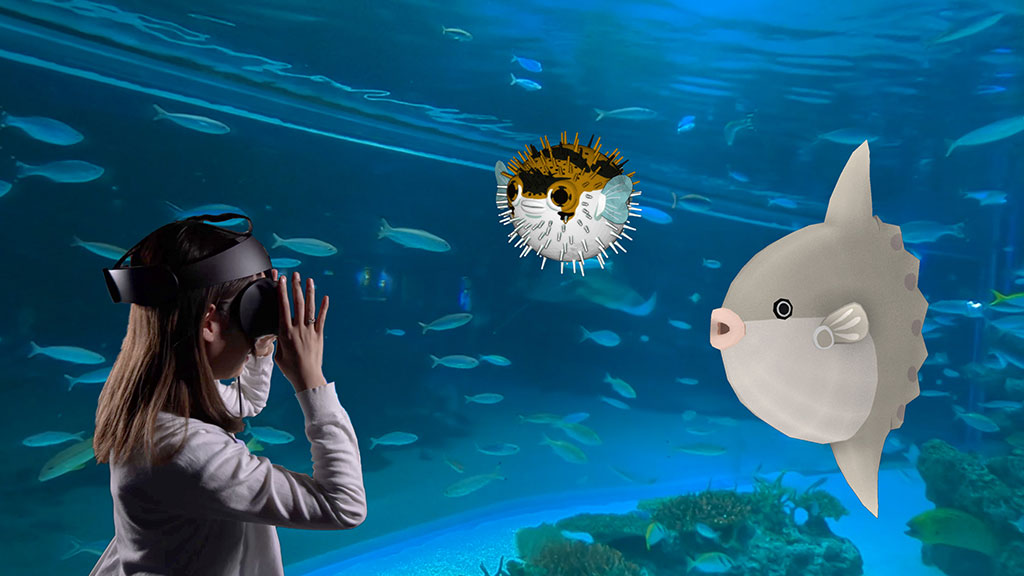

360度映像は決まった視点から外側を見る映像ですが、広い範囲での視点の移動に対応するため、ボリュメトリック映像を3次元空間に配置し、レンダリングにより映像を生成する方法が考えられています。今回開発したシステムでも、この方法を用いています。

ボリュメトリック映像とは、物体を取り囲むようにカメラを配置し、全方向から撮影することで、物体の立体的な構造を保持している映像です。このボリュメトリック映像を表現する方法として、ポリゴン(グラフィックスにおける多角形)とテクスチャ(多角形に貼り付ける画像)を組み合わせる方法とポイントクラウドを用いる方法があります。ポイントクラウドは3次元空間の画素の集合として物体を表現していて、それぞれの画素はその位置情報と色情報を持っています。ポリゴンとテクスチャの組合せでボリュメトリック映像を表現する方法に比べ、なめらかな曲面を精度よく表現でき、高画質化に適しています。こうした特徴に着目し、今回開発したシステムにおけるマンボウとハリセンボンの映像は、このポイントクラウドで表現しました。

MPEGでは、このポイントクラウドを2次元映像を対象に開発された映像圧縮符号化方式で圧縮する方法を開発し、「ボリュメトリック映像の符号化と映像ベースのポイントクラウド圧縮」 (MPEG-I パート5)として標準化しました。

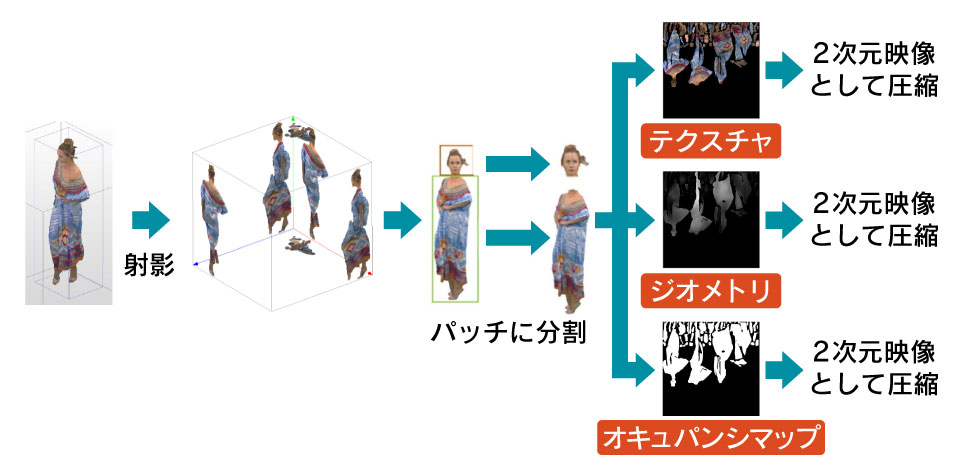

ポイントクラウドを圧縮符号化するための前処理の概要を以下に示します。立体的な構造を持つポイントクラウドを、それを取り囲むバウンディングボックスに射影し、さらにパッチと呼ばれる単位に分割します。それぞれのパッチをテクスチャと呼ばれる矩形の領域に配置することで、2次元の映像として扱うことができるようになります。それに加え、バウンディングボックスの射影面までの距離情報を示すジオメトリ、さらに矩形のテクスチャにパッチが配置されていることを示すオキュパンシマップ、の合計3つを映像信号として圧縮符号化します。これらの符号化ストリームと、パッチごとの3次元空間上の位置を示す補助情報を組み合わせることで、ポイントクラウドの圧縮ストリームが構成されます。

今回開発したシステムにおけるマンボウとハリセンボンの3次元映像は、このようにして圧縮符号化され、リアルタイムに復号して表示しています。

○3次元空間を記述するためのシーン記述

シーン記述は、3次元空間における3次元映像の位置などを時系列に示す情報です。時間に応じた3次元映像の位置と向きや大きさなどを指定します。3次元空間における360度映像や3次元映像の位置と、見る人の位置や視線方向をもとにレンダリングすることで、映像空間内を自由に移動して全方位の映像を見ることができます。今回開発したシステムでも、このシーン記述を用いて3次元映像の位置や大きさを指定しています。

MPEGでは、Khronos (さまざまなプラットフォームで動作するグラフィックスやメディア処理に関するオープンな規格を開発しているコンソーシアム)が開発し、3Dモデルを表現するために広く用いられているglTF2 (GL Transmission Format)を、動画像やポイントクラウドを取り扱えるよう拡張する検討を進めていて、「MPEGメディアのためのシーン記述」 (MPEG-Iパート14)として2021年10月の標準化完了を目標にしています。2021年6月現在、国際規格案が作成されており、以下のような拡張がglTF2に行われています。

- 外部のメディアソースの参照

- 動画のような時間方向の情報を持つメディアのサポート

- 動画の受信と表示のための循環バッファのサポート

- ビデオテクスチャのサポート

- 空間オーディオのサポート

- 推奨ビューポートの記述

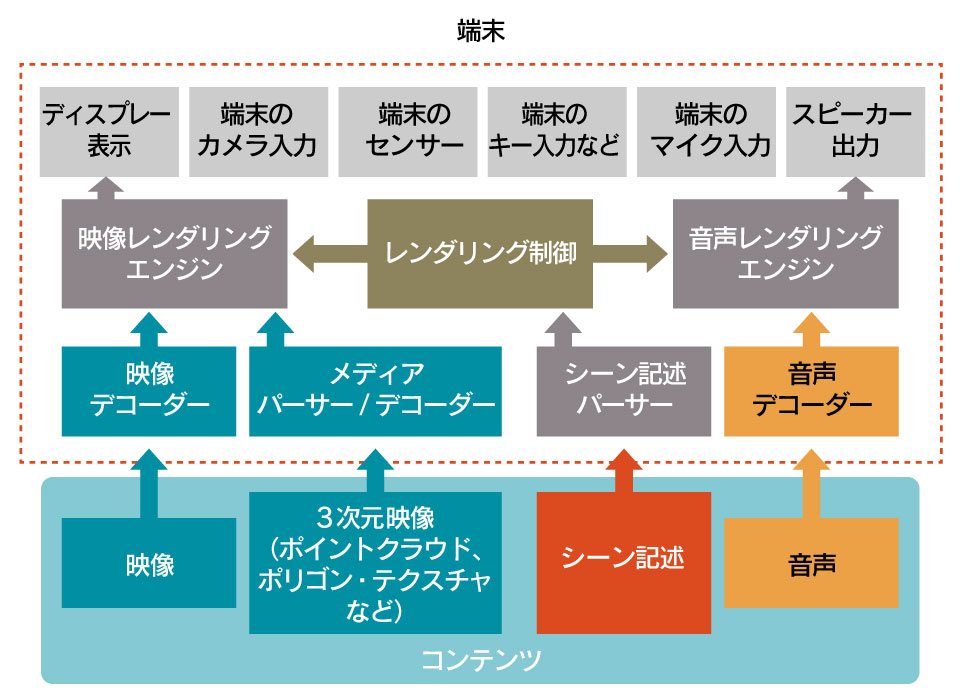

シーン記述にもとづき、映像も音声もレンダリング制御を行う端末のアーキテクチャの概要を以下に示します。